Nella prima settimana di febbraio 2017 c’è stata la Interaction Design Week a New York. organizzata da IxDA e guidata dal tema “Make it here, make it anywhere“. Io e Anna abbiamo comprato il nostro biglietto l’estate scorsa, abbiamo colto l’occasione per fare qualche giorno di ferie e goderci per la prima volta questa città incredibile.

Ho provato a raccogliere in 3 post gli appunti che ho preso durante questi 3 giorni nei talk che ho seguito. Visto che è pronto, inizio a pubblicare il primo. Gli altri due post sono in costruzione.

Nel primo giorno i temi generali toccati hanno riguardato il potere del design e AR / VR. Il primo pomeriggio era diviso in 3 track e ho seguito quella su design conversazionale e chatbots.

La location no, il catering sì

La conferenza era ricca di speaker, aveva un programma molto intenso perciò è stata distribuita in tre location: il Metropolitan Pavilion, che ospitava la main conference, e poi l’SVA e il FIT, che sono due spazi distanti circa 10 minuti a piedi.

L’SVA era ben segnalato, il FIT invece è stato faticoso trovarlo perché c’era solo un cartello tipo pub all’esterno e nessuna segnaletica all’interno.

L’area per la main conference al Metropolitan Pavilion è stata ricavata dividendo l’ambiente in due con delle tende che fungevano da quinte. Da questa suddivisione hanno ottenuto un’area per gli sponsor e i break, e una seconda area per la conferenza. Le tende, però, non sono bastate a isolare gli ambienti, perciò l’insonorizzazione dei posti a sedere più verso il fondo della sala era compromessa dai rumori che arrivano dalla sala adiacente. In più in quella zona c’era freddo. I posti erano sedie (non poltroncine) troppo vicine tra loro e non c’erano punti di facile accesso per la ricarica dei device, le informazioni per la wi-fi erano poco chiare, la visibilità del palco e delle slide era compromessa dalle numerose colonne presenti in sala. Sempre per via della location, nel day 1 e day 2 (decisamente più affollati) abbiamo mangiato per terra o in piedi, perché i posti a sedere erano davvero troppo pochi.

Quindi no, la location non mi è piaciuta.

Ottimo invece il catering. Ogni giorno ha avuto il suo tema (pranzo greco nel day 1, asiatico nel day 2, mediterraneo nel day 3), caffé, torte, biscottini e dolcetti ovunque, birra a fine giornata. Alè!

Tira una certa aria

Fin dal benvenuto di Josh Clark e John Payne, era evidente che i contenuti della conferenza sarebbero stati condizionati dal particolare momento storico che stiamo vivendo, con toni ironici o preoccupati. Questo clima lo abbiamo respirato anche in giro per la città. Da questo punto di vista, purtroppo New York non mi sembra rappresentare l’America attuale.

Si è parlato ovviamente di tecnologia e interazioni, ma soprattuto di impatto sociale, etica ed educazione, di buono e di cattivo, di potere e di responsabilità, della capacità del design di guidare intenzionalmente verso una posizione. Oggi questi argomenti sono arrivati agganciati a eventi di attualità politica verso i quali sono percepibili enormi imbarazzi e interrogativi.

Mi appunto qui il travel ban e questa notizia (marginale ma significativa), per ricordarmi che cosa sta succedendo in questi giorni.

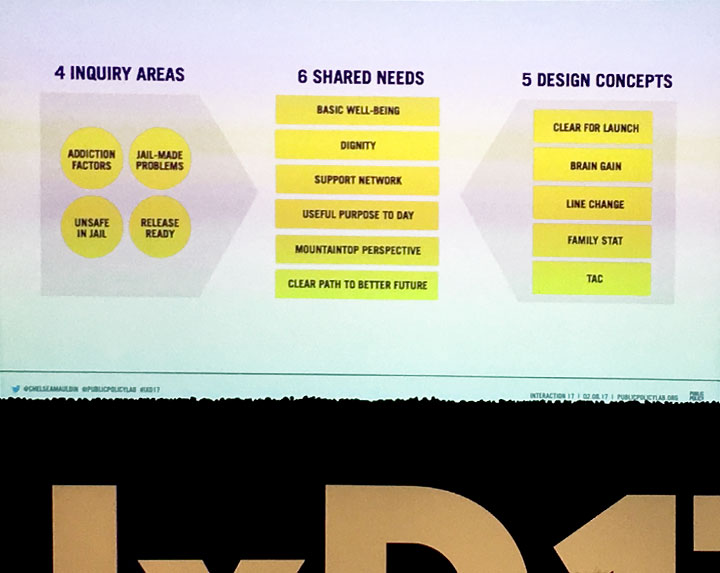

Un keynote da brividi: Design and Power

Chelsea Mauldin è direttore esecutivo della Public Policy Lab, il suo keynote era guidato da esperienze progettuali fatte nelle carceri con i detenuti, oppure nelle scuole con studenti diversamente abili. Per mesi lei e il suo team hanno intervistato non solo loro (detenuti e disabili), ma anche tutte le persone che condividono con loro luoghi e servizi. In questo modo hanno capito come li vivono e come contribuiscono a strutturarli. Ha costruito un talk davvero bello e pieno di domande grandi.

Quando progettiamo qualcosa siamo abituati a fare ricerca con persone che hanno un livello sociale, culturale ed economico simile al nostro. Che cosa succede se progettiamo qualcosa per persone che hanno una situazione molto diversa dalla nostra, per motivi economici, sociali, fisici o culturali? O perché vivono in un regime di semilibertà o in condizioni di analfabetismo? Siamo abituati a rapportarci con chi fa business e lavora negli uffici, perché è da loro che riceviamo indicazioni sugli obiettivi del progetto. Ma chi beneficia della progettazione? Quali sono le implicazioni morali ed etiche?

Nel caso dei progetti fatti nelle carceri o nelle scuole, la Mauldin ha preso in considerazione non solo i detenuti ma anche tutti coloro che lavorano nel carcere (guardiani, polizia, addetti vari) o nella scuola (professori, bidelli, assistenti…).

Ha suggerito una parola chiave per interpretare al meglio il ruolo del designer in contesti di questo tipo: “Fiduciary”, ovvero “meritevole di fiducia“. Il designer lo è quando

- ha a cuore il contesto (care): non lascia correre e prova fino alla fine a fare un buon lavoro;

- è leale (loyalty) con gli interlocutori: dice apertamente che cosa può o non può fare o garantire e mette gli utenti – tutti quelli che interagiranno con il servizio – al primo posto, davanti ai clienti;

- mostra obbedienza (obedience) verso i desideri espressi da loro.

Ci ha ricordato che il design deve essere a misura dei diritti, della situazione e del contesto che vivono le persone per le quali progettiamo e che se ce lo dimentichiamo possiamo creare un disagio molto grave. Nel caso dei detenuti, per esempio, il contesto emerso da decine di interviste viene descritto da parole come paura, timore di diventare malati mentali, senso di colpa, timore per quello che ci sarà dopo il carcere.

Infine ha suggerito 4 modi per conferire potere a ciò che progettiamo:

1) dobbiamo avere ben presente che gli utenti sono i proprietari del servizio, stiamo progettando qualcosa che sarà loro;

2) solo dopo averli visti come proprietari, possiamo vederli come utenti, immaginandoli mentre lo vivono come un qualcosa che gli appartiene;

3) ampliare lo sguardo sulla portata del servizio, cioè pensarlo in tutto l’impatto che avrà sul contesto e sugli utenti/proprietari;

4) nominare il corpo fisco, perché la situazione fisica può essere limitata (chiusa in cella, ridotta in capacità motorie ecc…) ma quella digitale può andare oltre questi vincoli.

AR / VR sono sulla cresta dell’onda

Nei talk successivi si è parlato di Augmented e Virtuali Reality.

Brenda Laurel ha fatto un talk eclettico e brillante. Devo ammettere che finora non ho avuto una grande opinione sulla Realtà Aumentata o su quella Virtuale.

Il motivo è che per ora le ho viste usare in modi molto futili, se non stupidi, oppure in contesti molto lontani da me (per esempio il gaming). La Laurel mi ha aiutato a vederli con occhi un po’ diversi, grazie a un paragone particolarmente azzeccato. Mi ha ricordato che invenzioni come il telescopio o il microscopio sono nate da un sogno che sembrava impossibile (e quindi eretico): vedere l’invisibile. Queste tecnologie hanno dimostrato il loro vero potenziale con il tempo. Sta succedendo così anche con VR e AR, che hanno iniziato a mostrare cose molto interessanti, per esempio con applicazioni tipo i simulatori di volo di Boeing (2004).

Brad Crane e John Mann hanno parlato di VR come metodo di prototipazione dell’esperienza. L’aspetto positivo è che consente di far risparmiare e apprendere prima ancora di avere speso un soldo in prototipazione fisica. Il punto più critico riguarda la ricerca con gli utenti, che sappiamo essere buona quando gli utenti danno informazioni basate su situazioni vere. La prototipazione in VR è per definizione verosimile (si spera) ma non vera, quindi la ricerca con gli utenti va progettata in modo che i bias derivati dalle simulazioni siano ridotti al minimo o comunque gestiti.

Gary Hustwit ha parlato di storytelling e VR, riguardo al suo intervento rimando direttamente a questo post su Medium, che anch’io mi rileggerò con calma.

Conversational UI e chatbots: al confine tra narrativa e progettazione

Nella prima parte del pomeriggio ho scelto di ascoltare i talk su chatbot e conversational UI.

Ha iniziato Elizabeth Allen di Shopify, che sta sperimentando i bot per servizi B2B di consulenza virtuale verso i propri clienti. Ha condiviso 5 lezioni imparate:

1) le persone si aspettano che i bot saranno mediamente scadenti, perché credono che daranno meno informazioni in un tempo maggiore;

2) “We shape our tools and thereafter our tools shape us” (la Allen ha attribuito questa quote a McLuhan, ma forse non era sua). In un talk del day 3, non ricordo più chi ha fatto un esempio molto in linea con questo concetto: prima abbiamo progettato le auto, poi quando hanno iniziato ad essere abbastanza affidabili e diffuse, sono nati i motel. Ecco, con i bot è la stessa cosa: al momento sono strumenti incerti, ma tra qualche tempo ci apriranno nuovi scenari;

3) i bot possono sembrare insistenti anche se non hanno questa intenzione. Pensiamo per esempio alla velocità istantanea con cui rispondono e al fatto che siano disponibili 24 ore al giorno, 7 giorni a settimana. È davvero necessario? È proprio così che deve essere?

4) dare una personalità a un bot è certamente complesso. Per esempio: qual è il loro genere? È uomo o donna? Perché? I paesi anglosassoni hanno una lingua che, secondo me, aiuta a ragionare per generi anche neutri, non solo maschile e femminile. Ma da noi come può funzionare? Avremo un invasione di mascotte à la Poncho? Boh. Tutto qui?

5) Un’altra cosa certamente complicata da progettare riguarda il rapporto che si può creare tra una persona e il bot con cui sta dialogando. Ci si può fidare del bot al punto di dirgli “ricordami qualcosa?” oppure “se mi trovo lì fai questo”?

La Allen ha concluso consigliando di progettare il bot in modo che le sue capacità e i suoi limiti siano molto chiari all’utente, per settare le giuste aspettative e non tirarsi addosso il rischio di tradire la fiducia dell’utente.

Nel talk successivo, Greg Vassallo ha suggerito tra le altre cose un paio di tool da provare per iniziare a progettare conversazioni: Motion AI e Pullstring.

Nel terzo talk, Whitney French ha parlato di Intelligenza Emotiva e Bot, e mi è piaciuto molto. Ha suggerito 5 metriche da tenere in considerazione per un bot:

1) intelligenza (brain), cioè la capacità del bot di capire gli stati d’animo della persona con cui sta conversando e il contesto;

2) flusso e cadenza (beat): sono appropriati? Sono attesi?

3) capacità di essere d’aiuto (helpfulness): il dialogo con il bot è davvero d’aiuto? O alla fine le persone stanno solo impiegando più tempo per ottenere le informazioni che vogliono?

4) personalità (hook): qui la French ha fatto un confronto particolarmente illuminante tra Google Assistant e Alexa, osservando il loro comportamento rispetto a una di quelle domande sceme che gli utenti fanno per misurare il bot. La domanda era “Come si chiama mio marito?”. Google Assistant si sforzava di imparare e alla fine rispondeva con un “Mi hai detto che si chiama così”. Alexa, invece, è stata progettata per rispondere fin da subito con un “Se lo stai chiedendo a me, dovresti farti qualche domanda….” Non so se l’approccio Alexa sia vincente rispetto a Google Assistant, di certo appare più brillante… eppure in alcuni contesti la stupidità di Google Assistant potrebbe risultare più rassicurante, mentre l’irriverenza di Alexa potrebbe suonare strafottente. Ma la domanda continua a essere una: come si arriva a fidarsi di un bot? Su quali basi è costruita questa fiducia e perché?

5) utilità (heart): il bot con cui le persone conversano stanno davvero risolvendo qualcosa? Ed è più facile così?

Nell’ultimo talk, Elena Ontiveros di Facebook Messenger ha condiviso l’esperienza maturata nel progettare un bot per l’evento F8 (2014). Il suo team aveva in carico una serie di cose e il bot era una delle tante. Quando hanno iniziato a realizzarlo, si sono accorti di aver ampiamente sballato le stime e di aver sottovalutato la complessità del lavoro. Erano partiti avendo in mente di riuscire a far fare al bot quasi una decina di cose, ma alla fine sono riusciti a far funzionare bene soltanto la prima, cioè la più importante: dare informazioni sull’evento. I consigli principali che Elena ha dato sono stati due: dichiarare le aspettative e definire il contesto di un bot.

Come dicono da queste parti, “Designing a bot is a thing”, non c’è dubbio.

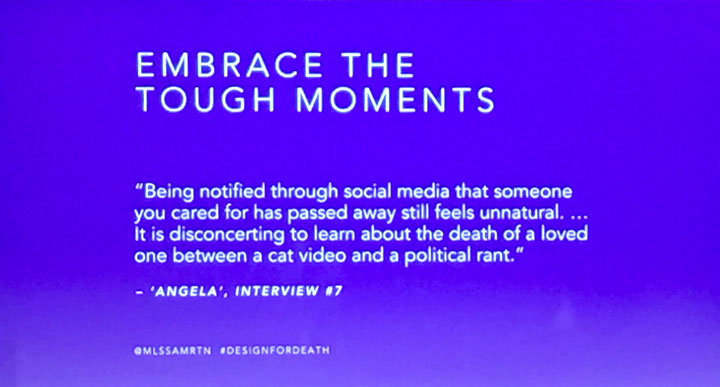

Goth tech

Prima del keynote di chiusura, ci sono stati 3 brevi talk (spark talks). Uno di questi, Final Destination di Melissa Martin, riguardava il che cosa succede al corpo digitale quando sopravvive al corpo fisico. Iniziato con i necessari toni comic dark, questo talk ha toccato un argomento su cui ho iniziato a riflettere qualche tempo fa.

Per quanto riguarda innovazione e tecnologia, ho l’impressione che stiamo continuando a perderci alcuni passaggi importanti e che, in altri settori, abbiamo imparato ad affrontare in modo sistemico, pensandoli anche in una prospettiva a misura d’uomo. In questo caso, l’argomento cardine del breve talk della Martin riguardava l’asse temporale futuro, ovvero che cosa ne sarà di ciò che ho reso pubblico di me quando non ci sarò più. Sono andata a curiosare su come Facebook ha deciso di gestire queste situazioni e, per me, le due opzioni che offre sono molto deludenti. Facebook è solo un esempio, il punto è comunque uno: stiamo progettando soluzioni tecnologiche senza pensare a che cosa succederà dopo che i proprietari di quei contenuti non ci saranno più. Il fatto di non sapere come sarà la tecnologia tra qualche anno sta diventando un alibi perfetto per evitare di rispondere a queste domande, fa tanto comodo così. Mi sembra tutto un brutto déjà vu.

Stiamo progettando per il web come se fosse un ambiente a breve termine o, meglio, un ambiente in cui le persone sono congelate nel tempo. Solo product lifecycle, niente human lifecycle.

L’approccio artistico e divertentissimo di Brendan Dawes

La prima giornata si è chiusa con un talk di Brendan Dawes che definirei artista o inventore tecnologico. British, irriverente e appassionato, ha condiviso il suo punto di vista alla tecnologia e in pochi minuti è riuscito a farcela vedere come uno strumento che non dovrebbe servire ad altro che a renderci più umani ed emotivi. Quando ripenso al suo talk, non riesco a fare meno di notare che tante delle cose che progettiamo oggi continuano ad obbligarci a scendere al livello della macchina.

La cosa peggiore è che questa situazione molto spesso ci giustifica ad avere comportamenti almeno tanto stupidi quanto lo sono le macchine.

“We shape our tools and thereafter our future shape us”, precisamente.